Die massenhafte Auswertung von Daten schickt sich an, unsere Wirtschaftswelt zu revolutionieren: Sie ermöglicht neue, bessere Produkte, zufriedenere Kunden und optimierte Prozesse. Gleichzeitig stellen sich aber auch Fragen der Datensicherheit und wie diese Volumina zu bewältigen sind. Erfahren Sie, was genau Big Data ausmacht, welche Einsatzgebiete es gibt und wie die Umsetzung gelingt.

Die ahd ist seit 2021 Teil der Proact Gruppe.

Unsere neuesten Blogbeiträge findest du ab sofort auf dem Proact Blog.

Klick dich rein und bleib up to date!

Inhalt dieses Blogbeitrags

Schön, dass Sie hier sind! Wie Ihnen vielleicht schon aufgefallen ist, verwenden wir aus Gründen der Lesbarkeit in erster Linie die männliche Form in unseren Texten. Im Sinne der Gleichbehandlung meinen wir damit selbstverständlich immer alle Geschlechter (m/w/d). Und jetzt wünschen wir Ihnen viel Spaß beim Lesen.

Definition: Was ist Big Data?

Big Data bezeichnet eine große, heterogene Menge von (meist digitalen) Daten, die laufend zunimmt. Das spiegelt die klassische Definition des Analysten Doug Laney wider. Er charakterisierte Big Data unter Verwendung der drei Vs:

- Volume: die Datenmenge

- Velocity: die Veränderungsgeschwindigkeit

- Variety: die Datenvielfalt

Big Data ist eine Begleiterscheinung der Digitalisierung. Durch die zunehmende digitale Transformation aller Lebensbereiche werden ungleich mehr Daten erzeugt als in einer analogen Welt. Diese gilt insbesondere für das sogenannte Internet of Things. Hierbei werden Gegenstände wie Waschmaschinen, Autos oder Industrieroboter mit Sensoren ausgestattet, um fortlaufend Nutzungsdaten einzusammeln. Diese riesigen, ständig zunehmenden Datenberge können unter Verwendung von Artificial Intelligence und im Speziellen von Machine Learning ausgewertet werden. Man spricht hier von Big-Data-Analytics.

Auf diese Weise lassen sich Muster ausmachen, die bisher nicht bekannt waren. Beispielsweise könnte ein Energieunternehmen seine Stromnetze besser aussteuern, indem das Nutzerverhalten zu bestimmten Zeitpunkten wie Feiertagen oder Ferienzeiten analysiert wird. Oder eine Produktionsstätte könnte anhand von Betriebsdaten genau vorhersagen, wann Maschinen gewartet werden müssen (Predictive Analytics).

Bei Big Data muss zwischen strukturierten und unstrukturierten Daten unterschieden werden. Erstere liegen in einer standardisierten, auswertungsfähigen Form vor, zweitere sind uneinheitlicher und müssen gegebenenfalls zuerst aufbereitet werden. Generell besteht die Herausforderung darin, die tatsächlich aussagekräftigen Daten aus dem „Noise“ herauszufiltern. Die dafür benötigten Anwendungen werden zunehmend als flexible Serviceleistung aus der Cloud angeboten.

Big Data ist eine wesentliche Komponente moderner digitaler Geschäftsmodelle. Bekannteste Beispiele in diesem Bereich sind Alphabet, das Unternehmen hinter Google, und Meta (vormals Facebook). Beide Organisationen verwenden Big Data dazu, auf den User zugeschnittene Anzeigenplätze zu verkaufen.

Die 3 klassischen Vs

Big Data wird häufig unter Verwendungen der drei großen Vs beschrieben. Diese gehen auf den Gartner-Analysten Doug Laney und seine Meta-Group-Studie aus dem Jahr 2001 zurück.

Volume

Big Data zeichnet sich wesentlich durch ein nie dagewesenes, exponentielles Datenwachstum aus. Es wird erwartet, dass bis 2025 ein weltweites Volumen von rund 180 Zettabyte erreicht sein wird. Dabei besteht die Herausforderung weniger in der Speicherung, sondern in der Auswertung dieser Daten.

Velocity

Velocity nimmt Bezug auf die unglaubliche Geschwindigkeit, mit der Daten mittlerweile generiert werden. Beispielsweise werden bei Instagram ungefähr 65.000 Fotos pro Minute hochgeladen, Google empfängt fast 4 Millionen Suchanfragen und es werden knapp 150 Millionen E-Mails in dieser Zeit verschickt.

Variety

Daten liegen in immer mehr unterschiedlichen Formaten vor. Die wichtigste Unterscheidung betrifft strukturierte vs. unstrukturierte Daten. Strukturierte Daten sind einfach zu verarbeiten und zu analysieren, weil sie bereits in vergleichbarer Form verfügbar sind. Beispiele sind Namen, Datumsangaben, Adressen, Kreditkartennummern oder Aktiendaten. Unstrukturierte Daten müssen dagegen erst aufbereitet werden, um eine Vergleichbarkeit herzustellen. Beispiele sind Audiodateien, Videos, Photos, Social-Media-Posts und Textdokumente.

Die 4 neuen Vs

Um den neueren Entwicklungen im Bereich Big Data Rechnung zu tragen, haben Experten vier weitere Vs vorgeschlagen.

Veracity

Veracity lässt sich mit “Wahrhaftigkeit” übersetzen. Der Begriff bezieht sich auf die Qualität der erhobenen Daten. Nur wenn die Informationen valide sind, lassen sich wahre, aussagekräftige Schlüsse ziehen. Dieser Punkt gewinnt insbesondere im Zuge der Automatisierung an Bedeutung. In Zukunft werden Entscheidungen zunehmend von künstlichen Intelligenzen getroffen werden. Diese können aber nur mit den Informationen arbeiten, die wir ihnen zur Verfügung stellen. Die Veracity ist also Grundvoraussetzung.

Variability

Daten sind Veränderungen unterworfen. Beispielsweise kann ein bestimmtes Wort in einem Kontext positiv und in einem anderen Kontext negativ besetzt sein. Big-Data-Analytics muss solchen Bedeutungsverschiebungen durch komplexe Algorithmen Rechnung tragen.

Visualization

Damit Big Data gewinnbringend genutzt werden kann, müssen die Ergebnisse visualisiert werden. Das gilt insbesondere für den Moment, in dem Big-Data-Findings die IT-Abteilung verlassen und einem nichttechnischen Publikum präsentiert werden. Die beste Analyse hilft nichts, wenn die Informationen vom Management nicht in Geschäftsentscheidungen übersetzt werden können.

Value

Letztlich geht es bei Big Data um die Frage, welcher Return on Investment sich durch eine Analyse erzielen lässt. Der Aufwand muss in einem guten Verhältnis zum generierten Mehrwert stehen. Das können beispielsweise zufriedenere Kunden, größere Margen oder geringere Produktionskosten sein.

Welche Einsatzgebiete es gibt

Big Data kommt in ganz verschiedenen Bereichen und Industrien zum Einsatz.

Produktentwicklung

Ein ideales Einsatzgebiet für Big Data ist die Produktentwicklung. Es werden bestehende Nutzungsmuster analysiert, um Ideen für zukünftige Produkte zu entwickeln. Netflix ist ein Unternehmen, das diesen Gedanken konsequent umgesetzt hat. Der Online-Streaming-Dienst wertet genau aus, welche Genres und Serienformate bei den Zuschauern am besten ankommen. Dafür werden unter anderem die Anzahl der geschauten Folgen und Staffeln betrachtet, welche Serien sofort wieder abgebrochen wurden sowie Korrelationen zwischen Alter, Geschlecht, Herkunft und Filmauswahl untersucht. Auf dieser Grundlage investiert der Medienriese nicht nur in die Produktion neuer Serien; er individualisiert auch, welche Serien dem Nutzer in der App vorgeschlagen werden.

Fertigung

In der zukünftigen smarten Fabrik werden alle Maschinen mit Sensoren ausgestattet sein, die fortlaufend Produktionsdaten erheben. Diese können für ganz unterschiedliche Zwecke genutzt werden:

- Die Wartung von Maschinen kann genau dann erfolgen, wenn diese tatsächlich nötig ist. Eine vorbeugende, oftmals unnötige Wartung in regelmäßigen Zeitintervallen entfällt damit.

- Maschinen werden in die Lage versetzt, selbstständig miteinander zu kommunizieren. Fällt beispielsweise eine Fertigungsstrecke aus, kann der Maschinenpark sich selbstständig neu organisieren, um den Verlust wett zu machen.

- Mit den gesammelten Daten kann ein digitales Abbild der eigenen Produktion erstellt werden, der sogenannte digitale Zwilling. Hier lassen sich beispielsweise neue Produktionsstrecken unter Realitätsbedingungen simulieren.

Costumer-Experience

Big Data hat viel Potenzial für die Verbesserung der Customer-Experience. Jeder Kontaktpunkt mit dem Kunden kann via AI ausgewertet und anschließend optimiert werden. Das betrifft beispielsweise aufgezeichnete Telefonanfragen und Chat-Protokolle. Auch die Interaktionen des Kunden mit dem Unternehmen auf Social Media oder über die Unternehmenswebsite bieten viele aussagekräftige Daten. Damit gehen wichtige Vorteile einher:

- Suboptimale Kontaktpunkte können optimiert werden, um die Kundenzufriedenheit zu steigern.

- Supportkosten können reduziert werden, weil sich bestimmte wiederholbare Vorgänge automatisieren lassen.

- Eine optimierte Customer-Experience trägt zu einer besseren Reputation bei, zum Beispiel durch positive Onlinebewertungen. Diese können als Verkaufsargument gegenüber der Konkurrenz in Stellung gebracht werden.

Gesundheitswesen

Big Data verspricht große Fortschritte im Gesundheitswesen. Dies soll in Kombination mit sogenannten Wearables geschehen, also Auslesegeräten, die von den Patienten am Körper getragen werden. Durch die fortlaufende Analyse riesiger Mengen Vitaldaten ließen sich beispielsweise Herz-Kreislauf-Erkrankungen prognostizieren oder bestimmte Formen von Krebs. Auch für die Vorhersage von epileptischen Anfällen wären solche Verfahren gut geeignet.

In der Praxis hat Big Data im Gesundheitswesen aber noch mehrere Herausforderungen zu lösen:

- Der Schutz und die Anonymität der Patientendaten muss gewährleistet werden, insbesondere wenn solche Daten zwischen verschiedenen Organisationen wie Krankenhäusern und Versicherungen geteilt werden.

- Die Daten müssen auswertbar gemacht werden. Viele gesammelte Daten, insbesondere aus bildgebenden Verfahren, zählen zur Gruppe der unstrukturierten Daten. Auch selbst von den Patienten eingegebene Daten, zum Beispiel über das tägliche Befinden bei einer depressiven Verstimmung, haben einen schwer quantifizierbaren Charakter.

- Fehlmessungen müssen minimiert werden. Beim Einsatz von Wearables kommt es immer noch vergleichsweise häufig zu falschen Messdaten, unter anderem weil die Geräte nicht richtig eingesetzt werden oder weil es zu Verfälschungen durch Umweltfaktoren kommt.

Auch wenn Big Data im Gesundheitswesen aktuell noch eher Zukunftsvision als Realität ist, bieten sich hier doch große Chancen. Datengestützte Analysen führen erfahrungsgemäß schneller zu Durchbrüchen als eine auf Hypothesen basierende Forschung.

Public Sector

Big Data wird auch von Regierungen und staatlichen Einrichtungen verwendet, wobei die Nutzung durchaus umstritten ist. Ein besonders kontroverses Beispiel ist die “National Security Administration” (NSA) in den USA. Diese beobachtet insbesondere seit den Anschlägen vom 11. September 2001 verdächtigte Internetaktivitäten via Algorithmus, um Terroranschläge im Vorfeld zu erkennen und abzuwehren.

Es gibt aber auch unstrittige Einsatzzwecke, beispielsweise bei der massenhaften Auswertung von Notrufen während regionaler Katastrophenfälle. Außerdem stützen sich viele Smart-City-Initiativen auf Big Data, um die Stromversorgung zu optimieren oder den Abgasausstoß zu reduzieren.

Versicherungen

Versicherungen verwenden zunehmend Big Data, um finanzielle Risiken besser einschätzen zu können. Dafür werden zum Beispiel die folgenden Datapoints der Versicherungsnehmer einbezogen:

- Ernährungsweise

- TV-Konsum

- Sport und Hobbies

- Beziehungsstatus

Auf dieser Grundlage können die Versicherer besser einschätzen, welche Kosten auf sie zukommen und gleichzeitig Gesundheitsangebote an die Versicherungsnehmer machen, um diese Kosten zu reduzieren.

Die wichtigsten Vorteile

Big Data bietet eine Reihe wichtiger Vorteile.

Besseres Kundenverständnis

Dank Big Data müssen Sie nicht länger mutmaßen, was Ihr Kunde möchte – Sie können es anhand der Daten genau ablesen. Das trägt zu besseren Produkten, weniger Supportanfragen und einer höheren Kundenzufriedenheit bei.

Optimierte Prozesse

Ob bei der Auslieferung von digitalen Werbeanzeigen, bei Bestellvorgängen oder Herstellungsprozessen – mit Big Data decken Sie bisher verborgen gebliebene Optimierungspotenziale auf. Das liegt daran, dass Algorithmen Einsparungen oder Verbesserungen leichter hochrechnen können als Menschen. Es hängt aber auch mit dem psychologischen Umstand zusammen, dass die meisten Menschen Veränderungen scheuen. Eine entsprechend eingestellte Big-Data-AI hat dieses Problem nicht; sie konfrontiert uns im positiven Sinne mit vernachlässigten Chancen.

Besseres Supply-Chain-Management

Durch Big Data lassen sich oft Kosten beim Sourcing von Gütern oder Diensten einsparen. Der Algorithmus vergleicht falls gewünscht minütlich, wo aktuell die besten Preise zu haben sind. Aber auch im Lagermanagement und bei der Planung von Transporten lassen sich via Big Data viele Einsparungen erzielen, wenn beispielsweise nahe beieinander liegende Ziele in einem Transport zusammengefasst werden können.

Besseres Marketing

Big Data kann auf Grundlage in der Vergangenheit getätigter Käufe sehr genau vorhersagen, welche Produkte für ein bestimmtes Marktsegment interessant sind. So lässt sich Targeted Advertising betreiben, also das Einblenden von digitalen Werbeanzeigen, die genau auf den jeweiligen User abgestimmt sind.

Optimierte Fehlererkennung

Viele Probleme in großen Unternehmen ließen sich bisher schwer identifizieren, weil die zugrundeliegenden Datensätze so umfangreich waren. Mit Big Data machen Sie nun schneller Maschinen-Anomalien ausfindig oder erkennen Kostenfresser. Auch ungewöhnliche Cyberaktivitäten lassen sich so frühzeitig ausmachen.

Wie Sie eine Big-Data-Strategie entwickeln

Die folgenden sechs Schritte helfen Ihnen dabei, den optimalen Einsatz von Big Data in Ihrem Unternehmen zu gewährleisten.

1. Identifizieren Sie Know-how-Lücken

Big Data ist eine relativ neue Technologie, die gerade erst dabei ist, in vielen Unternehmen Einzug zu halten. Das Problem: Viele IT-Experten kennen sich noch nicht genügend mit der Methodik aus, um Big Data gewinnbringend einzusetzen, selbst wenn die entsprechenden Tools vorhanden sind. Deshalb sollten Sie zu Beginn den Status quo evaluieren: Welches Know-how ist intern vorhanden, welche Lücken bestehen?

Ergreifen Sie dann systematisch Maßnahmen, um diese Lücken zu schließen. Beispielsweise gibt es zahlreiche E-Learning-Angebote auf Plattformen wie Udemy. Auch die Hersteller von Big-Data-Software bieten oft entsprechende Schulungen an. Außerdem können Sie Know-how-Lücken durch die Einstellung dedizierter Big-Data-Experten schließen. Oder ziehen Sie externe Berater bzw. Managed-Services-Provider hinzu. Der Vorteil bei dieser Variante: Sie können exakt so viel Unterstützung einkaufen, wie Sie benötigen; “Overstaffing” wird vermieden.

2. Richten Sie ein Excellence-Center ein

Es geht nicht nur darum, das entsprechende Know-how ins Unternehmen zu holen: Es muss auch geschickt verteilt werden. Wenn nur wenige Ausgesuchte Bescheid wissen, ist der positive Nutzen für Ihre Organisation minimal.

Deshalb empfiehlt es sich insbesondere für große Organisationen, einen Excellence-Center einzurichten. Hier werden relevante Informationen, Techniken und Best Practices zentral für alle dokumentiert. Das kann ganz einfach in Form einer Unternehmens-Wiki geschehen, aber auch mit Projektbeschreibungen und selbst produzierten E-Learning-Angeboten kombiniert werden. Auf diese Weise pflanzt sich das Big-Data-Know-how ins ganze Unternehmen fort; die Investitionskosten amortisieren sich und die Mitarbeitenden werden weiter qualifiziert.

3. Identifizieren Sie Big-Data-Quellen

Es gibt unterschiedliche Kategorien von Daten, die Sie in Ihre Big-Data-Strategie einbeziehen können. Zu den wichtigsten zählen:

- Gestreamte Daten. Diese Daten stammen in der Regel von IoT-Devices wie vernetzten Maschinen, selbstfahrenden Autos oder medizinischen Wearables. Einige dieser Geräte verarbeiten die Daten mithilfe eingebauter Mikroprozessoren direkt (Edge-Computing), während andere die Daten via Sensoren nur auslesen und in die Cloud hochladen.

- Social-Media-Daten. Hier werden Content-Trends und User-Reaktionen auf Plattformen wie Facebook, LinkedIn oder Instagram ausgewertet. Relevant ist das vor allem für die Bereiche Marketing, Sales und Support. Aber auch die Produktentwicklung kann profitieren, weil User-Bedürfnisse schneller erkannt und in Lösungen übersetzt werden. Typischerweise erfordert diese Art von Daten einen höheren Nachbearbeitungsaufwand, weil eine Vielzahl von Medientypen (Text, Bilder, Videos, GIFs) vorliegen.

- Öffentliche und geteilte Daten. Auch die Analyse von öffentlichen Ressourcen wie Websites, Verlautbarungen, Gesetzestexten und allgemein zugänglichen Datenbanken kann sich lohnen. Für B2B-Unternehmen sind außerdem Daten interessant, die ihnen von Zulieferern oder Kunden zur Verfügung gestellt werden. Wenn beispielsweise ein Flugzeughersteller seinem Zulieferer Verschleißdaten von Bauteilen zur Verfügung stellt, kann letzterer diese für die Produktoptimierung nutzen, indem neue Materialien verwendet oder Schwachstellen verstärkt werden.

4. Wählen Sie Ihr Analyse-Vorgehen

Sie sollten immer eine Vorauswahl treffen: Welche Daten lohnt es sich jetzt zu analysieren und welche Daten können wir vorerst ignorieren? So halten Sie den Ressourceneinsatz überschaubar. Im zweiten Schritt sollten Sie sich mit der technologischen Umsetzung befassen. Hier reicht die Bandbreite von Grid-Computing über In-Memory-Technologien bis hin zu Machine-Learning-Anwendungen. Letztere können zunehmend als Service flexibel aus der Cloud bezogen werden (Machine-Learning-as-a-Service, MLaaS). Fast alle großen Anbieter wie Microsoft, Amazon, IBM oder Google bieten mittlerweile entsprechende SaaS-Lösungen an, zum Beispiel für Predictive Analytics, Risiko- und Kundenvorhersagen sowie Natural Language Processing.

5. Verbinden Sie Big Data mit bestehenden Daten-Sets

Viele Neuanwender von Big Data setzen ihre Analysen nicht ins Verhältnis zu früher erhobenen Daten. Dabei können solche Vergleiche schnelle Einsichten zu Tage fördern. Ein Beispiel: Setzen Sie die Kundenzufriedenheit Ihrer bisherigen Key-Accounts mit der Kundenzufriedenheit aller Käufer in Beziehung. Dasselbe gilt für früher erhobene Supplier-, Produktions- und Umweltdaten. So erhalten Sie direkt eine zeitliche Perspektive, obwohl Sie erst seit Kurzem Big-Data-Tools einsetzen.

6. Verwenden Sie Big Data mit einer Cloud-Lösung

Big Data benötigt gewaltige Rechenressourcen. Das betrifft sowohl die reine Speicherung der Daten als auch die Computing-Power zur aktiven Analyse. Ihren Usern sollte es möglich sein, jederzeit nach Bedarf neue Analytics-Sandboxes einzurichten. Teilweise müssen auf Grundlage der gewonnenen Daten auch noch Simulationen durchgeführt werden, um zu testen, dass die Daten richtig interpretiert wurden; erst dann kann der reale Prozess angepasst werden.

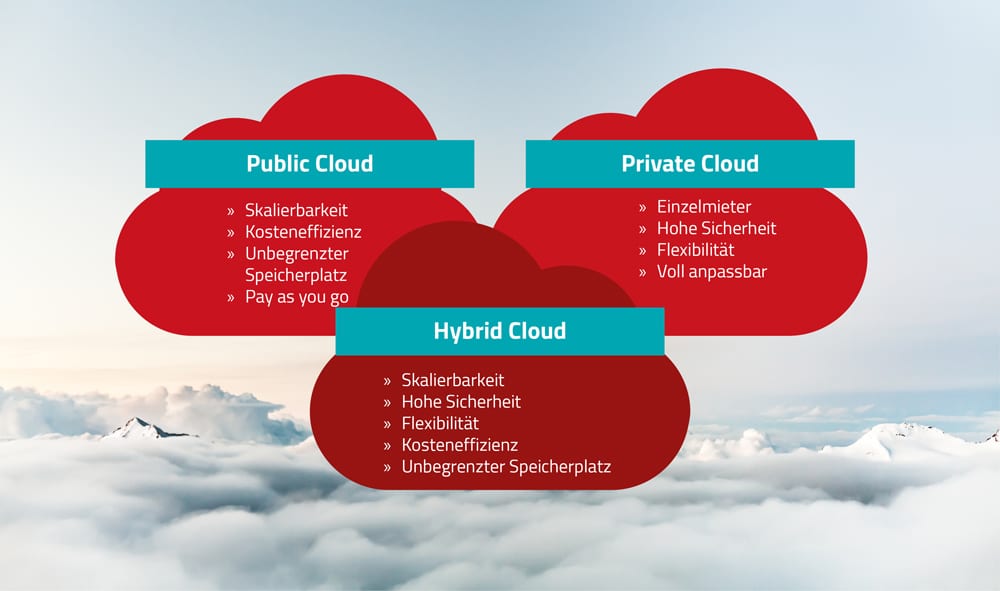

Klassische On-Premises-Infrastrukturen sind mit solchen Szenarien schnell überfordert. Sie brauchen stattdessen eine Lösung, die flexibel mitskaliert. Deshalb setzen viele Big-Data-Konzepte auf die Cloud als technologische Basis, wobei es hier durchaus unterschiedliche Ausprägungsformen gibt. Eine Public-Cloud-Lösung bietet meist günstige Kostenstrukturen. Eine Private Cloud ist dagegen besser für sensible Daten geeignet, zum Beispiel in der Versicherungs- oder Finanzbranche. Es gibt aber auch Modelle, die beide Ansätze verbinden, wie die sogenannte Hybrid Cloud. Und in einer Community-Cloud teilen sich mehrere Unternehmen mit ähnlichen Datenbedürfnissen denselben Cloud-Space.

Schaffen Sie die Basis für Big Data mit der ahd!

Sie möchten das technische Fundament für Big Data in Ihrem Unternehmen legen? Dann sollten wir uns unterhalten. Die Experten der ahd realisieren für Sie eine Vielzahl von belastbaren Cloud-Lösungen, auf denen Ihre Big-Data-Anwendungen aufsitzen. Das reicht von schnell skalierenden Public Clouds über besonders sichere Private Clouds bis hin zu hybriden Modellen. Auch beim Daten- und Change-Management sind wir Ihr zuverlässiger Partner.

Kontaktieren Sie uns jetzt über unsere Muttergesellschaft Proact für eine unverbindliche Erstberatung!

Die ahd ist seit 2021 Teil der Proact Gruppe.

Unsere neuesten Blogbeiträge findest du ab sofort auf dem Proact Blog.

Klick dich rein und bleib up to date!